随着技术发展,AI大模型的普及度越来越大,大部分人的使用方法都是打开一个AI的网页或者手机APP,但其实还有一种使用方法,可以解锁更多高级用法。

LLM API

API,全称是应用程序编程接口,你可以把它理解为两个软件组件之间的“信使”或“桥梁”。它定义了一套明确的规则,允许一个程序向另一个程序请求服务并获取结果。

LLM API 为大型语言模型提供的API。通过调用这个API,可以方便直接的从大模型提供商获取AI的回复,在外部程序中使用。

开始使用LLM API

使用AI大模型的API首先需要注册获取一个API KEY。有很多API平台提供了免费赠金,比如硅基流动,阿里百炼等。这里以硅基流动为例

点此链接进入硅基流动注册后即可领取14元赠金 https://cloud.siliconflow.cn/i/oVt4i82G

注册好了之后点击“余额充值”就能看到14元赠金已经到账。

之后点击侧边栏的“API密钥”,点击“新建密钥”,输入密钥描述后会得到一个“sk-”开头的密钥字符串

在第三方软件中使用大模型API

通过API调用,AI的能力可以变得无处不在。

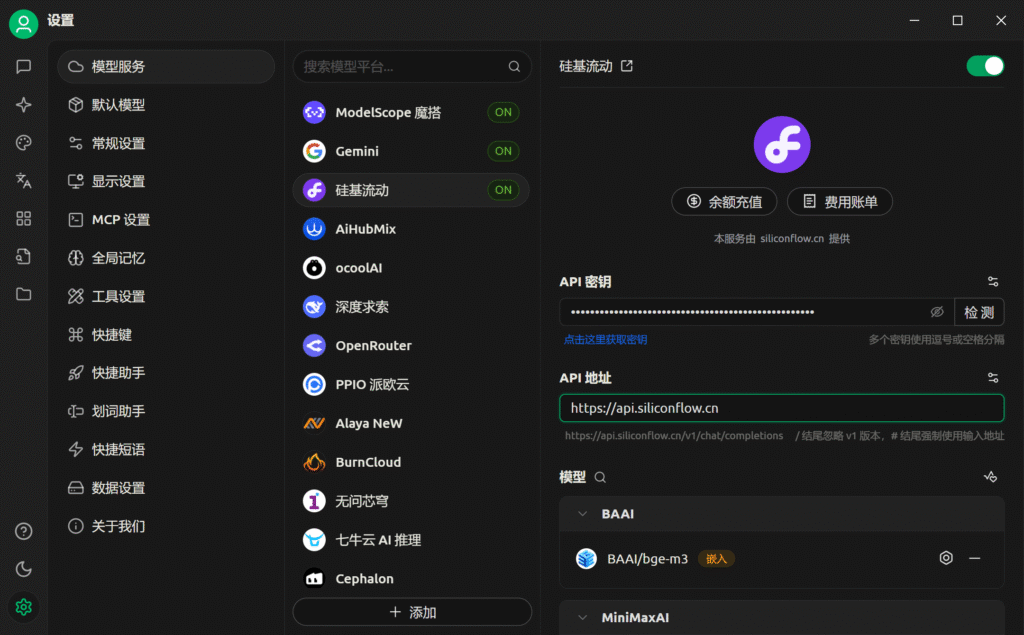

比如PC端软件“Cherry Studio”可以通过填写各个平台的API KEY调用大模型

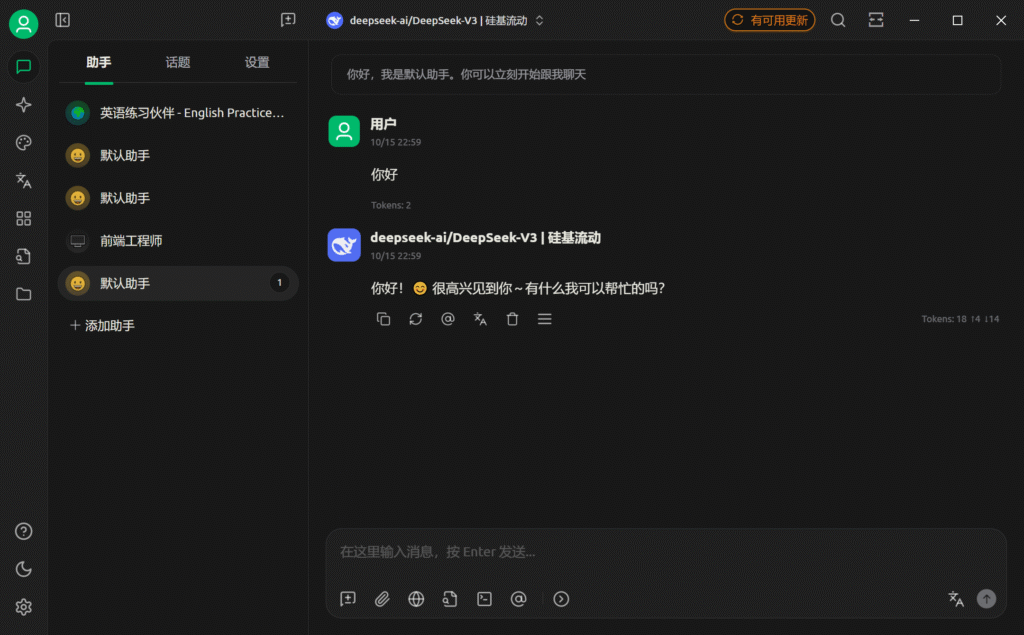

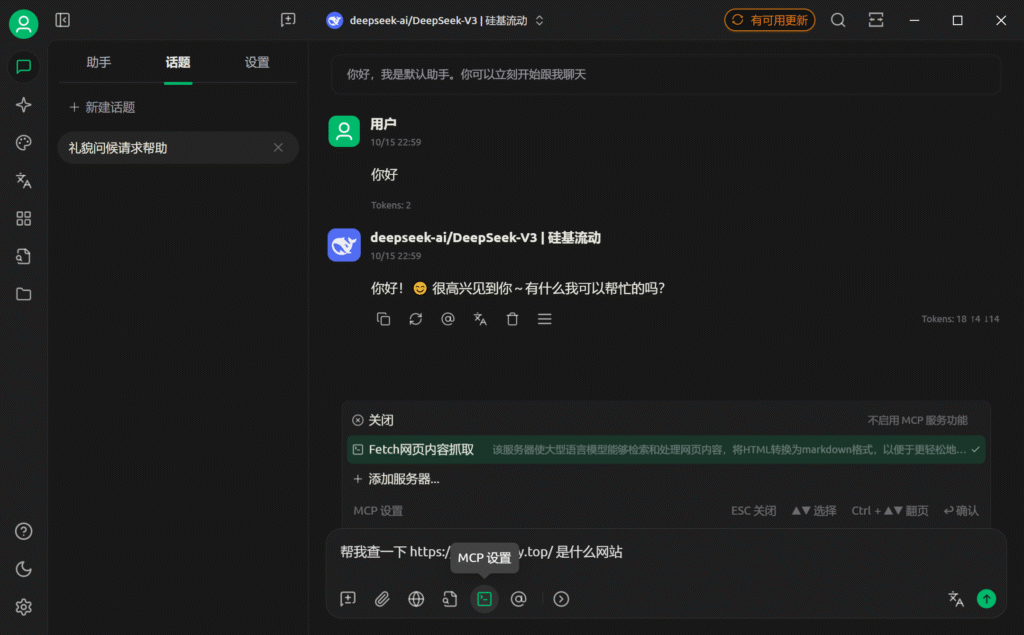

配置好API KEY之后就可以来到首页与AI聊天了,可以看到这个软件的聊天界面有三个标签页:助手、话题、设置

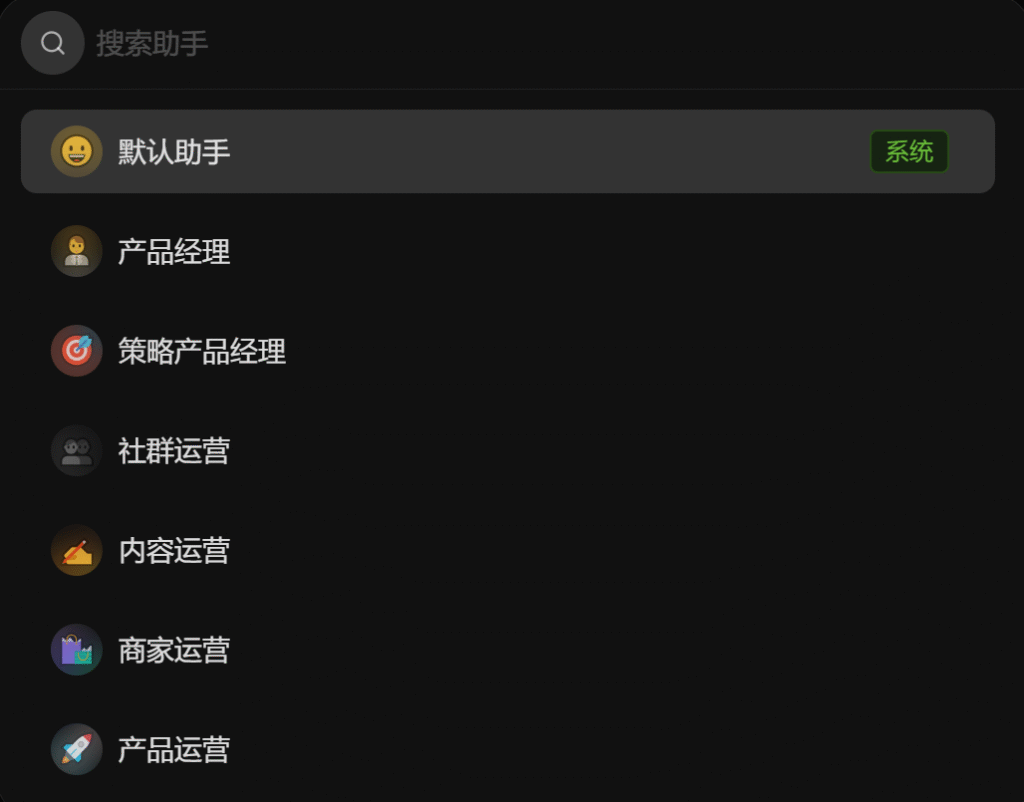

点击添加助手,可以看到软件内置了很多角色,不同的AI角色能在不同领域提供帮助

设置标签内还可以对对话进行更高级的设置,如调整模型温度,携带的上下文数量等

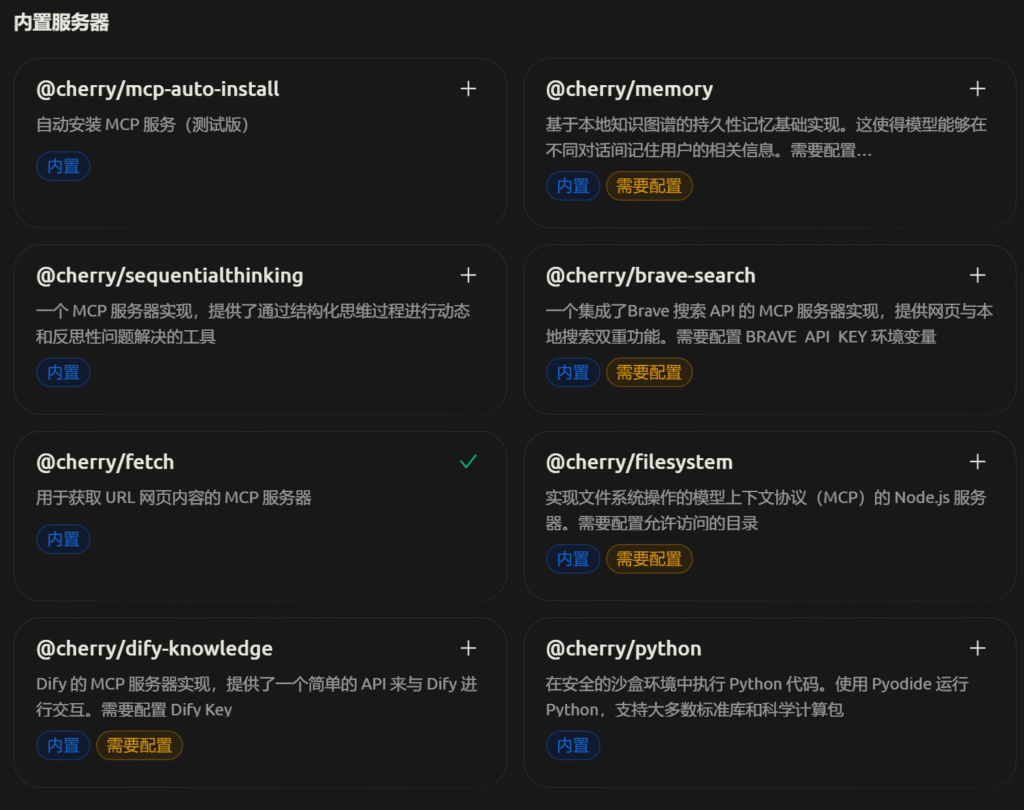

另外还有一个有意思的功能:MCP(Model Context Protocol),它可以让大模型使用外部工具,比如可以使用网页抓取工具获取一个网页的内容

Cherry Studio中还自带了很多实用的MCP工具

更多MCP工具可以再Model Scope找到:MCP 广场 · 魔搭社区

像 Cherry Studio 这样的 第三方AI 软件有很多,比如 Dify,ChatBox,ChatGPT Next Web,LM Studio等

在开源项目中使用大模型API

除了像Cherry Studio这样的第三方llm客户端,大模型API还可以使用在很多第三方项目中

AI翻译:沉浸式翻译 – 新一代AI翻译软件 | 双语对照网页翻译/PDF翻译/视频字幕翻译/漫画&图片翻译

AI聊天机器人:

AI桌宠:

- Lanlan Launcher:【已开源】AI已经进化到这个地步了吗?!_哔哩哔哩_bilibili

这里是我收集的很多AI驱动的开源项目:OneNav – AI分类,每一个都很有意思

在代码中使用大模型API

LLM API 最大的优势就是可以在程序中自由调用,上面介绍的开源项目就是如此,同样的,我们自己也可以通过编写代码来调用大模型接口:

import openai

client = OpenAI(

api_key="填写硅基流动API KEY",

base_url="https://api.siliconflow.cn/v1"

)

# 构建请求

response = openai.ChatCompletion.create(

model="deepseek-ai/DeepSeek-V3",

messages=[

{"role": "system", "content": "You are a helpful assistant"},

{"role": "user", "content": "用户的问题"}

]

)

# 提取并打印AI的回复

ai_response = response['choices'][0]['message']['content']

print(ai_response)你可能会感到疑惑,为什么调用 DeepSeek V3 需要导入 openai 库呢?其实这里的 OpenAI 库只是提供了一个API调用规范,并不是只能调用ChatGPT的大模型,通过设置base_url可以调用第三方平台的大模型能力,只要这些平台兼容了OpenAI的接口

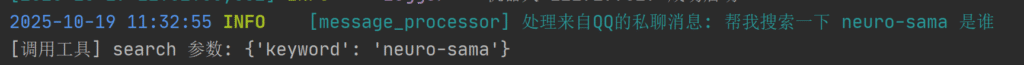

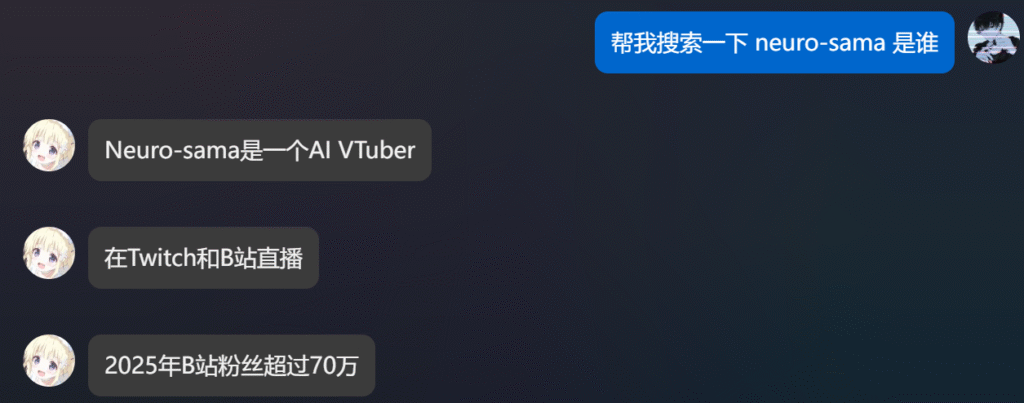

以上只是一个最简单的例子,你还可以在代码中使用 function calling 让大模型调用函数工具,做到更多事情。比如下面是我制作的 ai bot 通过调用工具搜索互联网上的内容

上图是我最近一直在开发的AI项目,目标是让 ai bot 像人一样对消息做出回应,目前已经大体上支持了QQ和Telegram平台,可以识别用户发送的图片,调用文生图发送图片,发送表情包,回应戳一戳和主动戳一戳等。这些都是通过调用大模型API来实现的。

结语

通过API调用AI大模型,可以极大的提高使用AI的灵活性,方便构建和使用AI项目。